Начиная с 2013 года в поисковых системах начались изменения в расчетах траста сайтов. В качестве примера интеграции новых методов расчета появился Яндекс Икс (вместо ТИЦ), а Google перестал обновлять PageRank.

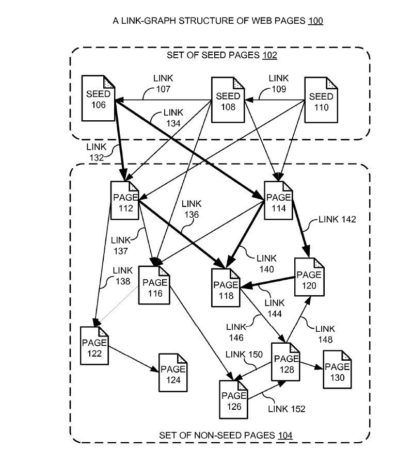

Что общего было у этих алгоритмов? Они использовали ссылочные графы для оценки качества донора и ранжирования сайтов. При этом в Яндексе использовался более совершенный алгоритм учитывающий только тематические ссылки (на то он и тематический индекс цитирования). Тиц и PageRank напрямую влияли на позиции сайтов по поисковым запросам.

Ситуация в Яндексе

Через время алгоритмы начали совершенствоваться, в Яндексе появился Матрикснет и уже стал влиять не только ссылочный вес с ссылок, но и стали учитываться другие факторы (анкор, спам на сайте, релевантность статьи анкору и т.д.). К чему это привело? К тому что переданный ссылочный вес стал резаться при условии что есть какие то негативные факторы влияющие на оценку (к примеру тот же платной ссылки, а не естественной).

В Яндексе с 2013 года после введения влияния поведенческих факторов на выдачу кроме ссылочных факторов начали использоваться и другие методы оценки (например те же коммерческие факторы). Как следствие влияние ссылочного стало все хуже и хуже, та как основная доля траста стала смещаться в сторону коммерческих факторов (для коммерческих запросов) и поведенческих (для информационных).

Ситуация в Google

По сравнению с Яндексом Гугл более архаичен. Поведенческие факторы тут работают, но не являются главными.

Остальные факторы — это текстовые, коммерческие и поведенческие.

В топ Гугла попасть без ссылок очень сложно.

Но последнее время Гугл начал плавно использовать метод оценки качества сайта кроме ссылок. Как пример — это использование метода оценки сайтов асессорами E-A-T (экспертность, авторитетность и надёжность сайта).

С 2015 года также работает Knowledge-Based Trust (КВТ) — алгоритм позволяющий проверять факты в текстах на истинность. Основа алгоритма — база в 2.8 миллиарда установленных факторов (основано на данных Википедии и других сайтов).

Даже сами ссылочные факторы совершенствуются. Например не так давно Google начал учитывать вложенность ссылок с релевантных страниц сайтов с высоким трастом по Knowledge-Based Trust(КВТ).

Как это работает на практике? В тематике формируются сайты с высоким КВТ(эдакие лидеры ниши). Далее для оценки качества других сайтов учитываются вложенность ссылок на другие сайты. Чем больше ваш сайт имеет ссылок с сайтов с высоким КВТ тем лучше в выдаче отображается ваш сайт. При этом учитываются не только прямые ссылки, но и ссылки через другие доноры на ваш сайт.

Как использовать данные на практике?

Для Гугла — нужно больше ссылок, желательно с сайтов которые являются лидерами в вашей тематике или пересекаются с вами по семантическому ядру. Так как ссылочные факторы очень сильны, то многие параметры определяющие ссылочный профиль хорошо работают. В качестве примера можно взять параметры Ахрефса DR и UR. Демо версию на 2 запроса можно проверить тут.

В то же время доля влияния ссылочного в Яндексе меньше 30%. Оценка качества донора только по ссылочному профилю устарела еще в 2013 году. Новых метрик так и не было введено и причина этому — полная деградация современного SEO продвижения. Многие компании не понимая как закупать ссылки под Яндекс просто отказались от закупки вообще. Закупка ссылок в биржах упала в разы и как следствие конкуренция снизилась и рынок просел.

Тем не менее существуют методы оценки качества донора с помощью оценки видимости в Яндексе. Сам метод не является панацеей, так как он не может определить причин падения трафика за счет устаревания контента.

Более подробно об этом я писал на блоге GGL. Кто не читал — можете ознакомиться:

К сожалению биржи ссылок не особо заинтересованы в методе оценки видимости на сайтах. А причина банальна — 95% сайтов в биржах не имеют позиций, а более 70 % просто под фильтрами и не годятся для закупки ссылок.

Я для себя использую свою программу для упрощения подбора доноров (с фильтром по Liveinternet,видимости Google и Яндекса). Ссылка на программу.

48 комментариев

Выставляй прогу

Прога твоя не нужна, оставь себе.

Интересно, выкладывай! Спасибо!

рулят ссылки и будут рулить))

Да, неплохо бы взглянуть на программу.

Очень нужен такой софт. Ты когда с помощью него закупаешь емть ощутимый эффект роста позиций?

Да, я об этом писал на блоге GGL. Работает. Но

1) Этот метод не универсальный

2) Доноров очень мало

3) Метод не в состоянии определить причину низкой видимости донора.

Спасибо за статью. Софт действительно был бы кстати. Выложите пожалуйста.

Неплохая инфа, как то оптимизаторы уходят от ссылочного вооббще

С какого Х. «95% доноров на биржах не имеют позиций»? На всех биржах русским по белому указана посещаемость сайтов, выбирай какие хочешь, конечно их не так много, но хватает в принципе

Очень советую проверять указанную посещаемость. И также смотреть на видимость, так как часто эта посещаемость накручена :)

Не знал, что можно накрутить статистику Симилавеб :О

А она и не соответствует действительности. Посмотрите плагином к примеру статистику моего блога.

Интересно потестить прогу!

Ппц ребят, и Denver, вы как будто застряли где-то в рунете 10-летней давности.

Прогрессировать не собираетесь?

Ну посвятите нас в новые данные. А то пока выглядит как «у меня яйца больше»

JS+NodeJS+фреймворки осваивайте, и *****дуйте на нормальную работу, ***** не майтесь.

Это лучший совет в 2019 году сеошникам, которые надеяться обогатиться на загибающемся рынке.

В принципе хороший совет любому человеку с учетом возможного Чебурнета. По поводу программирования — изучаю Python.

Но в SEO еще есть перспективы и деньги, поэтому не вижу смысла уходить с рудника :) .

А что там с Чебурнетом страшного? Мне лично на него в плане заработка плевать, будет как в Китае — рост местного сегмента интернета и замещение иностранных сайтов, напротив, часть трафика, идущего зарубеж, осядет на местном рынке, а значит посещаемость сайтов в рунете только повысится и возможно доход их владельцев.

Впрочем, на большинстве ниш это никак не скажется, те, кто искали информацию на русском языке так и продолжат её искать там же, а вот сайтам типа RuTube может подфартить, если доступ к YouTube и Vimeo будет перекрыт. Но даже китайский фаерволл пробивает огромная масса людей, а зная как у нас любят воровать бюджетные деньги на выделенные проекты, я не думаю, что по технологичности и качеству наши умельцы превзойдут в этом плане Китай. Так что выдыхайте)

Если вы не поняли смысл Чебурнета — это ограничение не только доступа к зарубежным сайтам, но и в Чебурнет извне.

Я украинец и у меня просто не будет доступа в сеть.

Почему, я понял это. Тем не менее, до «всё пропало, шеф» и «надо идти на завод», как кричат многие очень далеко. К тому же, прокси и vpn никто не отменял, смотрим на Китай)

Не стоит сравнивать Чебурнет и блокировку в Китае.

В Китае просто блокируется доступ и его можно обойти через VPN. Чебурнет предусматривает полный отказ от соединения своей сети с другими.

Как можно к чему то соединяться если соединения нет?

Весьма интересно написано, хорошее описание всё по делу. Конечно известны эти факты, но так хорошо сумировано всё. Спасибо.

Интесно было бы по поводу программы для упрощения подбора доноров. Что за программа? Я бы познакомился с этой идеей. Прошу написать

Очень годный пост!

По яндексу, мне кажется процент влияния ссылочного еще меньше.

Смотрел доноров на collaborator.pro?

там вроде биржа новая и основной упор делают на их посещаемость

Посещаемость смотрят по Similarweb, фильтр по Чектрасту. Но коммент.

Весь смысл статьи — але, пора просыпаться, внедрять новые метрики оценки траста.

Я обычно делаю так при отборе донора. 1. Чекаю список сайтов чектрастом. 2. Чекаю сайты на видимость в Serpstat на видимость запросов. 3. Сравниваю видимость с megaindex и определяю донора. Данную схуму юзаю больше 1.5 года. Ссылки более или менее тематичные, с нормальных доноров. Возможно даже чекнуть страницу на трафик. Но к сожалению, таких доноров очень мало и приходится тратить много времени на поиск. Зато результат всегда положительный.

Метод 100% рабочий. Но — это очень сильная выборка, я вообще удивляюсь что у вас доноры есть.

К сожалению демо версия в ахрефсе на два запроса в перестала работать, Евгений может знаете какую-ту альтернативу или способ обойти это ограничение, так как ахрефсом было удобно проверять сайты. Ну и за вашу програму по оценки видимости сайта именно в яндексе был бы благодарен.

Как перестало работать? Работает. Если кончились лимиты — смени IP на прокси.

По поводу программного обхода — это слишком большая проблема.

Пост очень полезный и софт безусловно нужен в паблик. Только непонятно, почему под Яндекс нельзя добывать ссылки тем же образом и по тому же принципу, что и под Гугл?

Для полноты картины очень не лишним было бы рассказать по какому принципу закупать ссылочное. Куда и когда его покупать: на главную, категории или сами страницы? Ведь есть же разница в распределении веса. К тому же, как определить, что какой-то группе запросов для продвижения не хватает именно ссылочного, может быть большую роль могут сыграть внутренние факторы.

Очень просто, я об этом написал в посте. На информационные сайты часто не закупаются ссылки. И как следствие если смотреть на донор только по DA,PA,MOZ ранку будет казаться что донор не подходит.

В Sape, GGL и других биржах, а также при крауд маркетинге используются как правило информационные сайты. Которые могут не иметь хорошее ссылочное, но тем не менее хорошо ранжироваться в поиске и передавать вес.

По поводу распределения веса — я бы уже не оперировал данным понятием, оно сильно устарело. Распределение веса — это принцип PageRank. В нем в качестве траста (веса) использовались только ссылочные факторы, не поведенческие.

По поводу определения ссылочного — я же написал — личное мнение — 30%. Другими словами любому запросу ссылки не помешают.

Не мог поставить оценку посту — звёздочки не работают.

Есть такое, в который раз глюкнул плагин.

Спасибо за статью! Софт нужен.

Евгений, подскажи, а у тебя был опыт покупки под Гугл в сапе? С нее вообще сейчас работает что-то и какие схемы?

Я слез с Сапы. Слишком много плохих доноров, а если покупать только тематичные — выбора вообще нет.

Работает меньше 1% доноров. И быстро теряют траст за счет спамных анкоров.

Евгений, спасибо! Подскажи, если можешь по ускорению индексации через социалки. Сейчас использую твитер через сервис twite.ru, но мне кажется это дорого. Делаю 2-3 ссылки в твитере по 3р. на 1 новую страницу, которую нужно ускорить. Это покупные статьи так ускоряю.

Есть работающие варианты подешевле? Сколько твитов нужно на твой взгляд?

Помогает при переиндексации страницы? Когда купил например в уже проиндексированной статье?

А зачем ускорять покупные статьи? Если не индексируются и не лезут в индекс — 100% проблема или с доменом или статьями.

Я делаю репосты в Фейсбук, яндекс хорошо видит такие ссылки. По поводу твитера — там процентов 5% твиттеров рабочих. Нужно проверять, потом делать вайт листы.

Еще по покупке ссылок. С ГГЛ и Миркой работать это все хорошо, но когда нужно на 300-400 статей купить по 1-2 ссылки, то уже начинаю задумываться о сапе(((

В таком случае проще качать общий траст сайта (если конечно по НЧ не сильная конкуренция).

Таким макаром скоро как в Бурже будем делать ПБН и скупать дропы для редиректов)

У тебя, кстати, не было опыта с подклейкой дропов на отдельные статьи?

Нет, зачем? Разве что под Гугл.

В Яндексе это не так сильно работает.

Добрый день.

«Но последнее время Гугл начал плавно использовать метод оценки качества сайта кроме ссылок».

Я бы посоветовал как-то перефразировать. Звучит не по-русски. Ну, на пример, Кроме ссылок Гугл стал использовать другие факторы и алгоритмы….

«Как пример – это использование метода оценки сайтов асессорами E-A-T»

E-A-T — это только критерии концепции, но не метод и, тем более, не алгоритм Гугл.

По этому, я бы советовал подправить.

Что касается оценки степени влияния ссылок — возможно так и есть. Точный процент никто не знает. Меня немного смутило слово траст — «…на траст сайта я бы оценил …»

Дело в том, что по официальной позиции ссылки (как один из факторов, по сути это — Page rank), влияют на расчет общего рейтинга сайта. Концепция траста действительно существует и, весьма вероятно, что ссылки на траст влияют, но она официально не подтверждена.

Относительно недавно я пытался разобраться в этом вопросе https://pro100blogger.com/2018/12/trust-site-avtoritetnost-sajtov-poiskovyx-sistem.html надеюсь вам и вашим читателям будет интересно. Если что, готов обсудить.

По поводу ошибок советую прочитать https://devvver.ru/kopirajteram/

Я не исправляю ошибки. Если кто то сильно хочет читать с исправлениями и на идеальном русском языке — пусть готовит денежку на корректора.

Как раз это методика для оценки асессорами. Эдакие правила.

Если я бы ждал подтверждения от Гугла каждого своего слова этого блога не существовало бы. То что ссылки влияют на позиции доказанный факт на практике.

По поводу траста — для меня это понятие равно слову любовь к сайту. Оно абстрактное, возможно имеет численное значение, но нам его никогда не покажут.

По поводу вашей статьи — если вы проводите какие то эксперименты всегда учитывайте причинно следственные связи. Иначе выводы получаются неправильные.

Спасибо за статью! Отстал я от жизни. Есть ли смысл в «Оригинальные тексты» в Яндекс-вебмастере?

Теоретически есть при условии что у вас воруют тексты. В других случаях не особо. Дело в том что данные используются для обучения нейросети.

Практически ваш сайт первоисточником не становится.

Евгений, а как думаете, сквозные ссылки сейчас стоит ли покупать? А то Сапа в рассылках всё навязывает.

В сапе я бы не брал. Очень мало доноров там осталось достойных.

А вот сами по себе сквозняки хорошо работают в Гугле, особенно если динамические и повыше в коде.