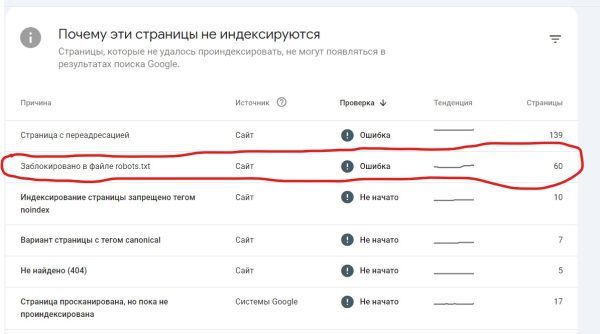

Последнее время Google сходит с ума — несмотря на запрет индексации некоторых страниц в robots.txt — упорно их пытается индексировать. В качестве примера можно показать индексацию rss лент комментариев.

Вот как это выглядит на практике:

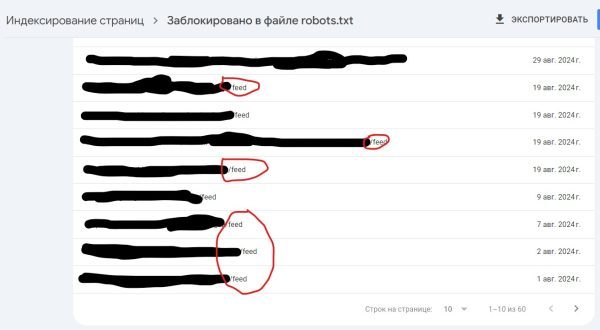

Если открыть проиндексированные url:

При этом в robots.txt есть блокировка индексации фидов:

Disallow: */feed

Чем это плохо?

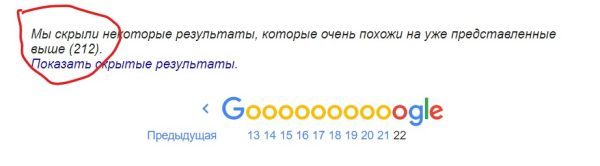

К сожалению после индексации подобные страницы улетают в «сопли» (так называемый дополнительный индекс).

Такие страницы тянут ваш сайт вниз, мешая полноценному ранжированию в Гугле.

Откуда взялась проблема?

Если прочитать инструкцию Google по закрытии от индексации, то он рекомендует использовать код для закрытия индексации:

<meta name="robots" content="noindex, nofollow">

Но для RSS лент это не возможно, это формат xml, не очень корректно туда вставлять такие теги. Причем это не основная лента вида site.com/feed , а ленты rss комментариев, которых у меня на сайте нет.

Для меня это решение не подходит, так как мне нельзя блокировать основную RSS и вспомогательные, так как они используются по назначению, в том числе для агрегации в Яндекс Turbo.

Решение проблемы: WordPress плагин

Для решения проблемы я создал плагин, который блокирует RSS ленты комментариев вида:

site.com/category/post/feed

site.com/post/feed

site.com/author/name/feed

Но оставляет RSS ленты вида:

site.com/feed

site.com/feed/turbo/

Что позволяет использовать Яндекс Турбо или другие RSS на сайте.

Что делает плагин ? Он прописывает 301 редиректы с фидов комментариев на посты. В принципе если вам такой вариант не нравится, можно отдавать 404 ошибку, отредактируйте плагин.

После установки я рекомендую дополнительно отредактировать robots.txt и временно удалить строки вида:

Disallow: */feed

У вас код может отличаться, но главное — это запрет на индексацию ленты. Я понимаю, что звучит странно, но вполне существует ситуация, когда Google робот не захочет заново пробовать переиндексировать закрытые страницы, поэтому это и нужно (понимаю что звучит как маразм, но так это и есть).

После этого ожидаем переиндексации, что может занять до несколько недель. Можно помочь с помощью переиндексации, используя API Google Console.

Только после того как Google переиндексирует страницы можно опять закрыть страницы от индексации. Плагин удалять не стоит.